DeepSeek(深度求索),我相信大家都使用过了,也不需要我过多的介绍他的作用和功能。来到这个页面的网友,应该大多数都是需要本地部署DeepSeek的一些网友。本地部署DeepSeek可以解决很多使用上的问题,比如说:服务器繁忙、隐私问题等,好处非常多。所以,大量的网友都想要在自己的电脑上部署DeepSeek。

但是,绝大部分网友还是第一次部署,还不知道怎么做。今天我就来做一篇详细的教程,来教大家如何在自己的电脑上部署DeepSeek!

DeepSeek本地部署详细教程

DeepSeek本地部署,一定是借用第三方工具部署的,通过第三方工具把DeepSeek的模型运作起来。下面给大家提供了两种可选方案!

一、DeepSeek+LM Studio本地部署

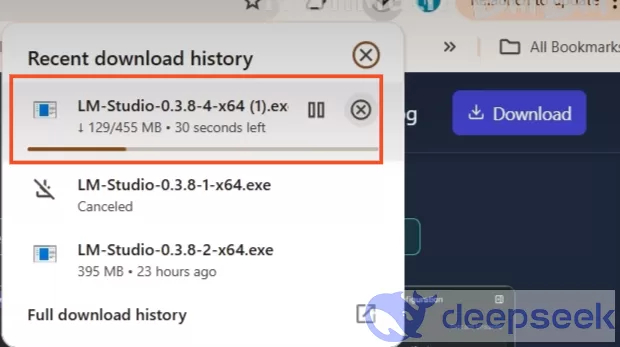

1、首先,在电脑里面下载并安装“LM Studio”。LM Studio的安装包我们会在文章结尾给上下载地址!

2、安装包下载之后,直接双击安装文件,即可成功安装LM Studio。

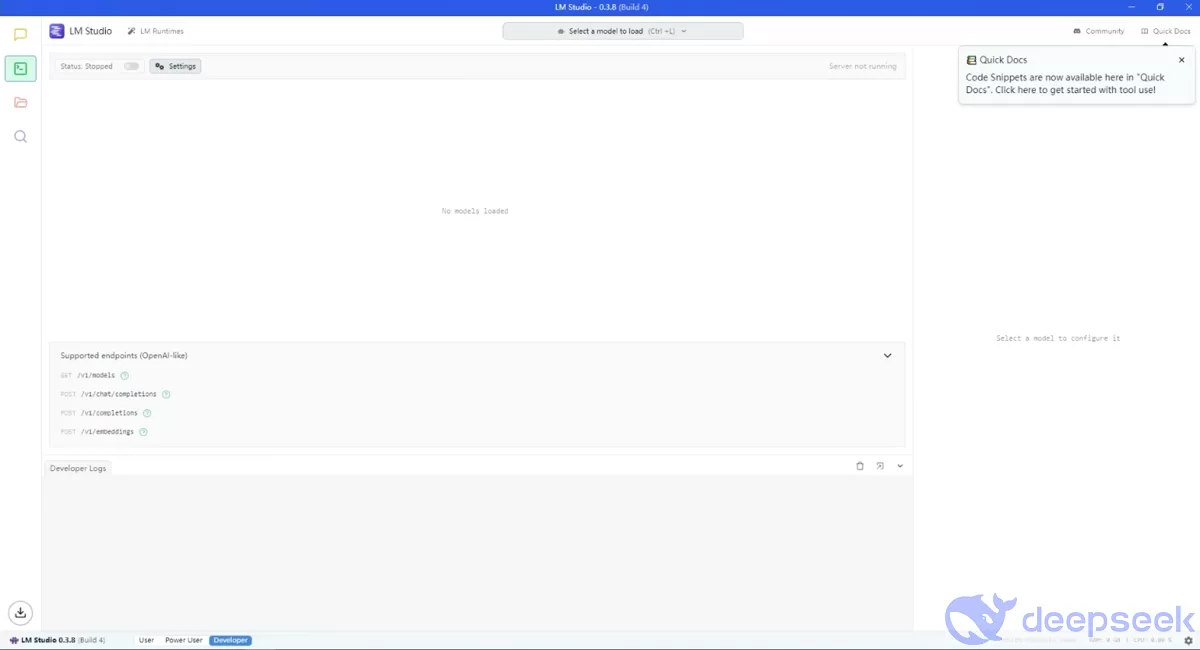

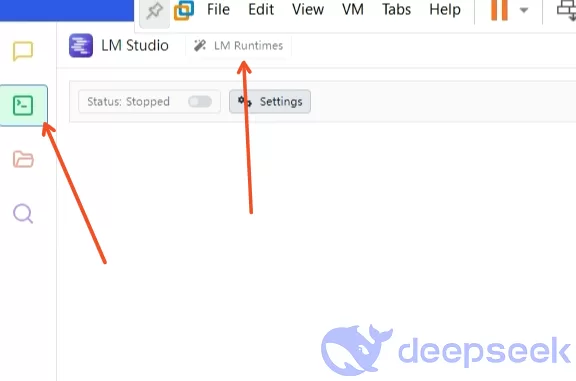

3、LM Studio安装完成以后,双击桌面图标,打开进入,我们就可以来到LM Studio的主界面。

4、在主页左上角点击点击“develop”,选择“LM Runtimes”。

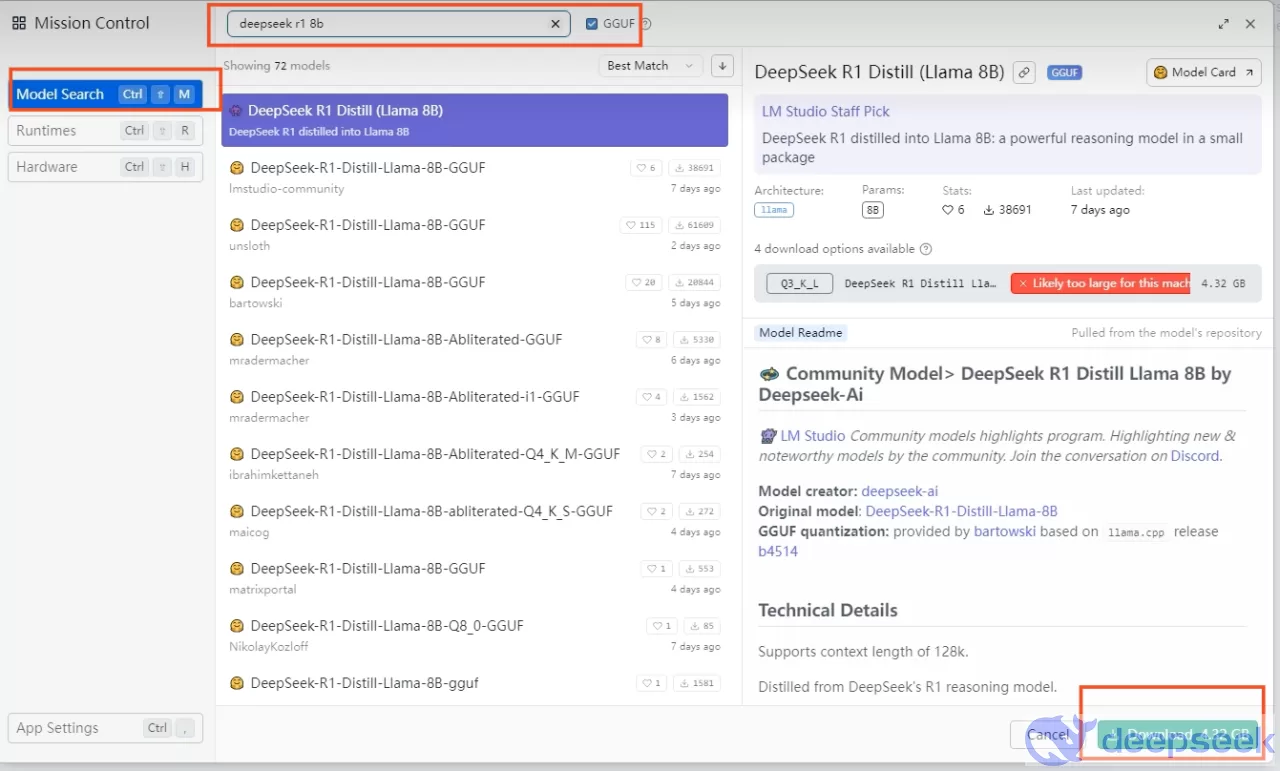

5、在进入的界面选择“Model Search”,在模型搜索栏目里面搜索“deepseek”,就可以找到deepseek的各个版本模型。本教程选择的是“deepseek r1 1.5b”,普通人来用足够了,要求更高的可以选择8b或者32b。选择好以后,点击右下角的“Download”。

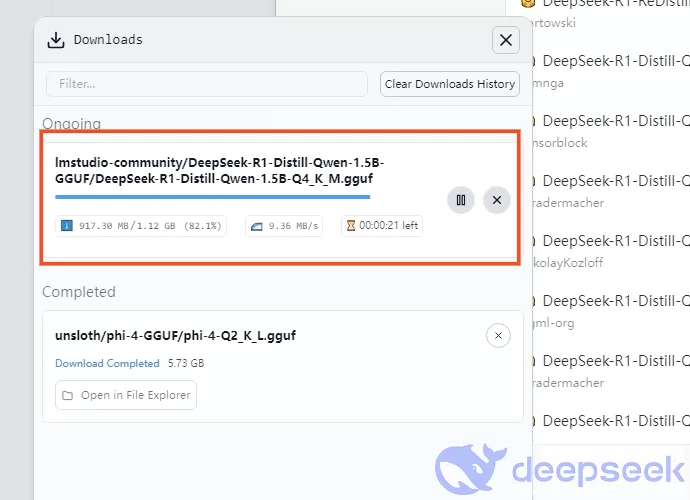

6、在左下角就会弹出来一个下载框,显示deepseek模型的下载进度,我们等待下载完成即可。

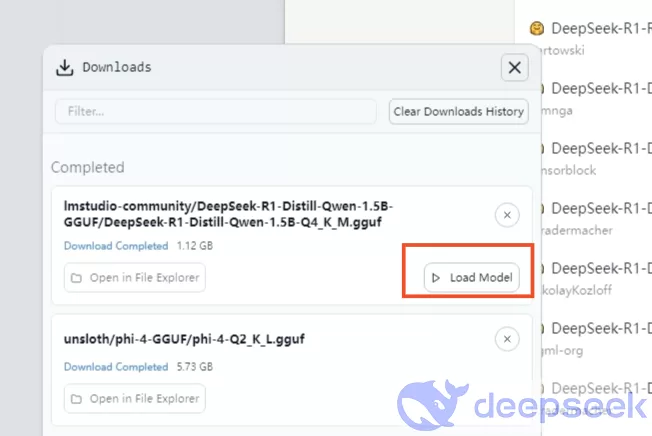

7、下载完成以后,我们点击“load model”,加载模型。

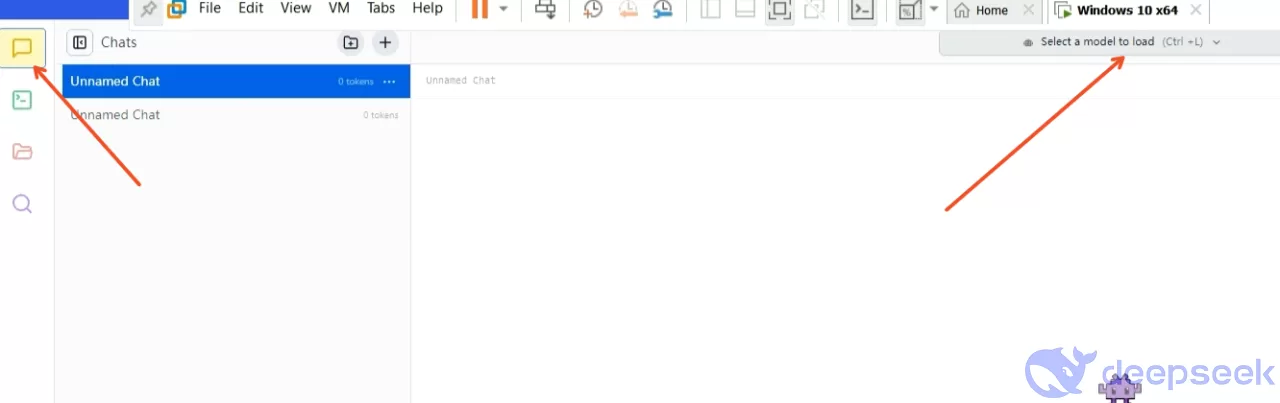

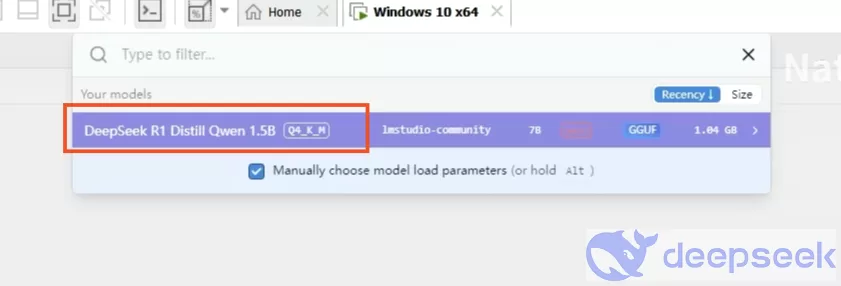

8、再点击“LM Studio”右上角的对话框窗口,在对话框界面顶部可以选择模型,点击“select a model load”。

9、这样就会弹出来我们刚才下载的模型,选择它。

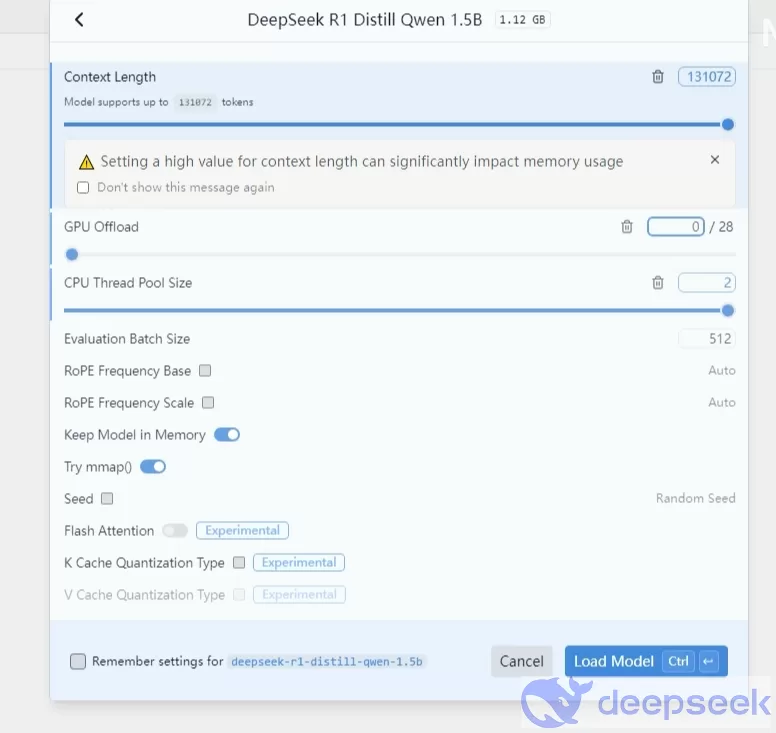

10、弹出来设置界面,这里我们可以设置文本总长度等,包括运行的配置选择,大家按照自己的需要设置。设置完成以后,选择“load model”。

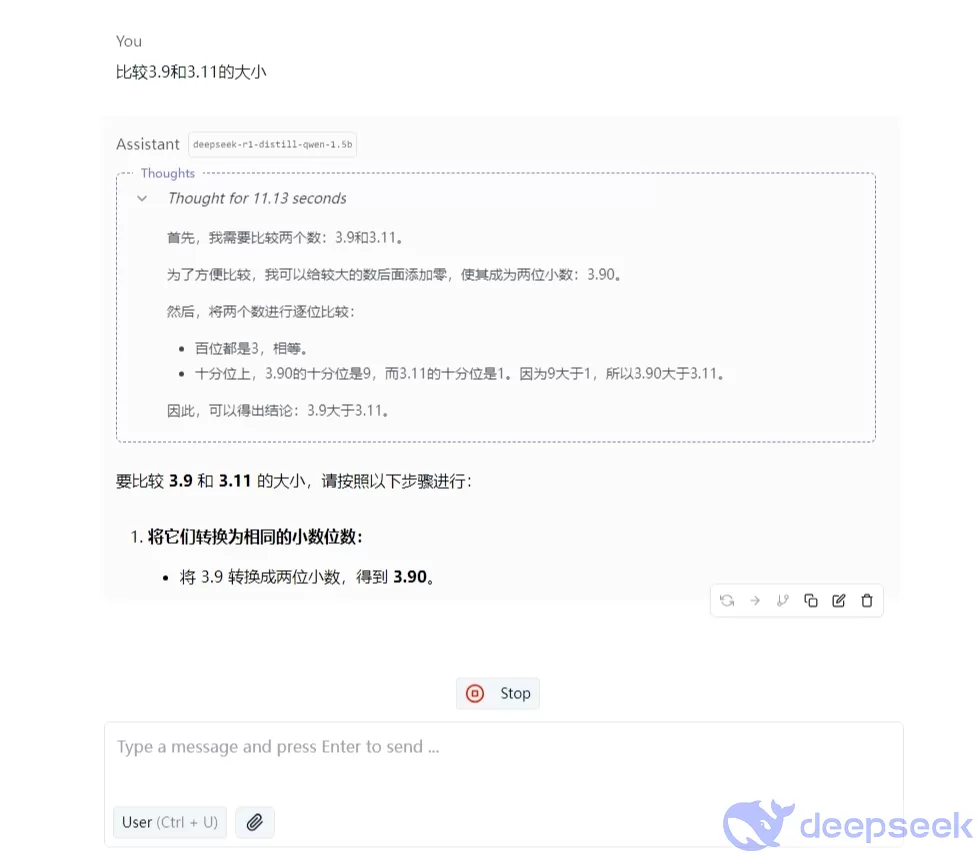

11、这样,我们就可以使用deepseek模型来进行问答了,大家可以随便提一个逻辑性的问题,看看它的推理过程是否正确。

以上步骤就是我们使用LM Studio来本地搭建deepseek模型的图文教程,相关软件的下载和视频教程,大家可以在文章结尾去下载!

二、DeepSeek+Chatbox本地部署

本方案是使用chatbox加载deepseek大模型来实现本地部署,详细教程看下面步骤!相关软件和视频教程在文章结尾也会给大家附上!

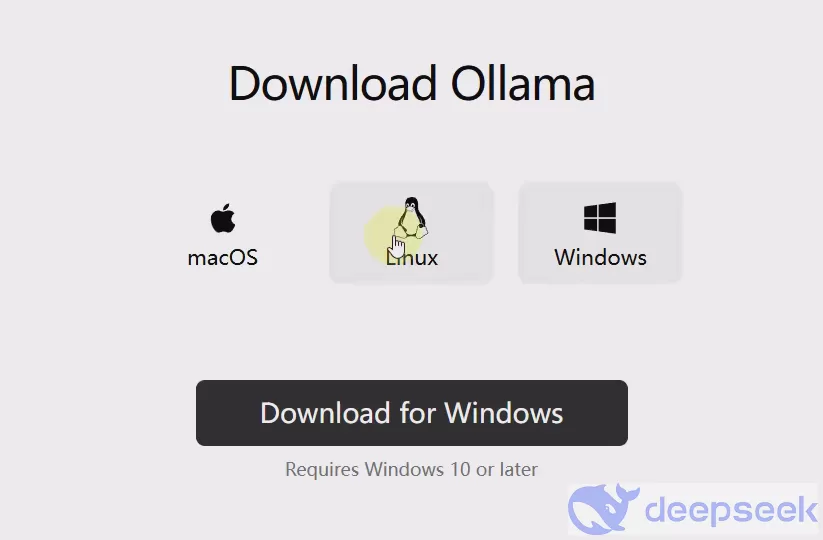

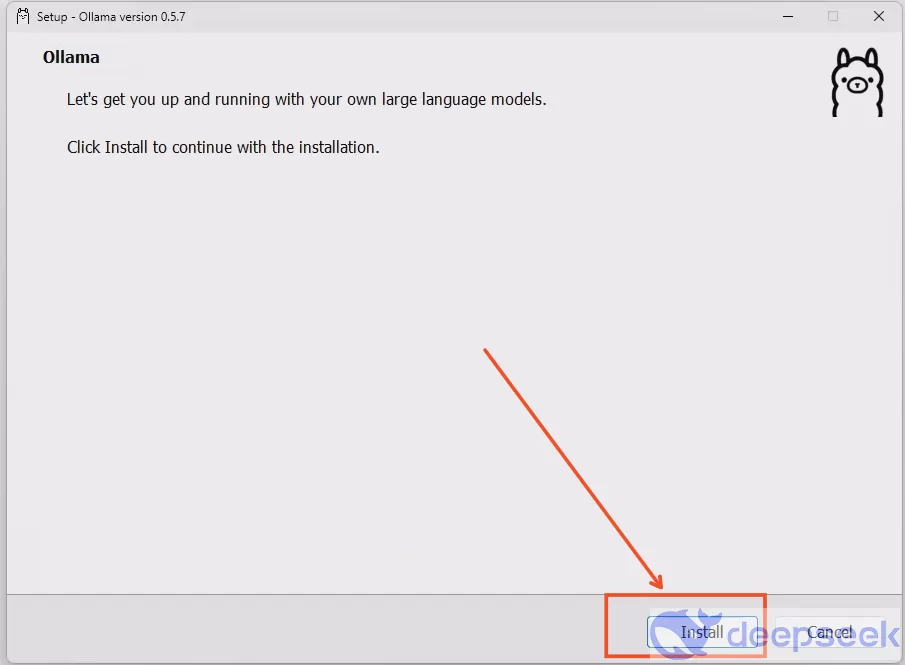

1、首先,在电脑上安装Ollama,至于为什么,就不多做解释,运行deepseek需要的。Ollama安装包,附件下载包里面有。

2、安装Ollama,双击Ollama安装包,点击“install”,下一步即可。

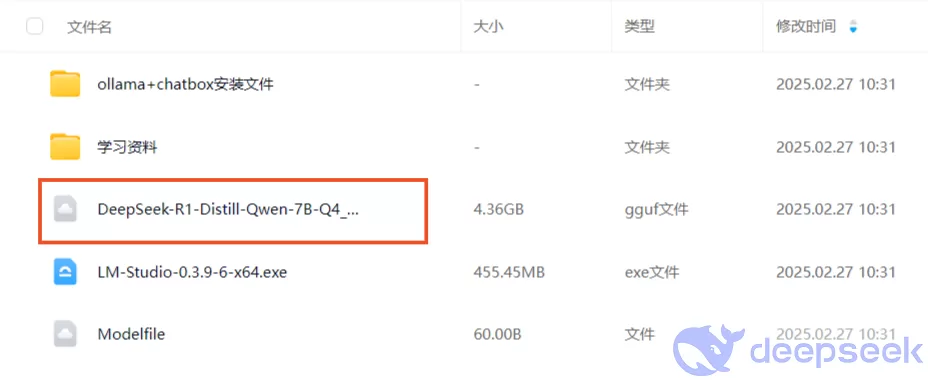

3、下载deepseek-R1模型,当然,我们给大家提供了多个模型,大家可以看配置选择。下载好以后,导入Ollama。

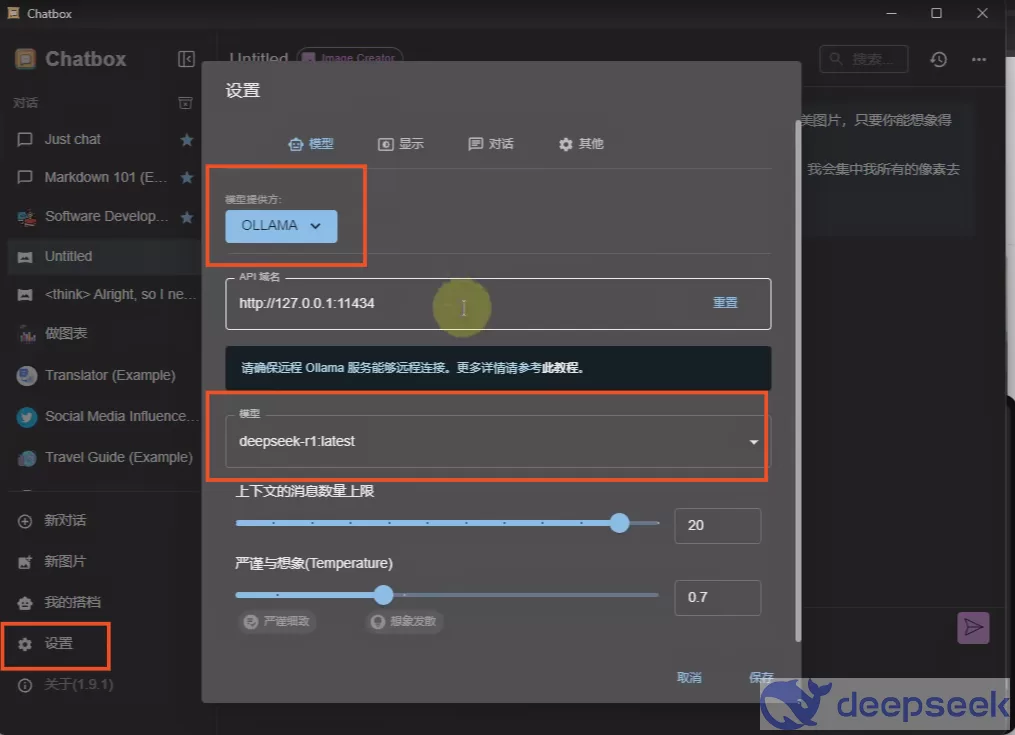

4、在电脑上安装chatbox安装包,安装文件附件里面也有。安装成功以后,在主界面点击“设置”,模型提供方选择“OLLAMA”,模型选择deepseek-r1,当然有多个模型,可以按照自己需要选择。配置好以后,点击保存。

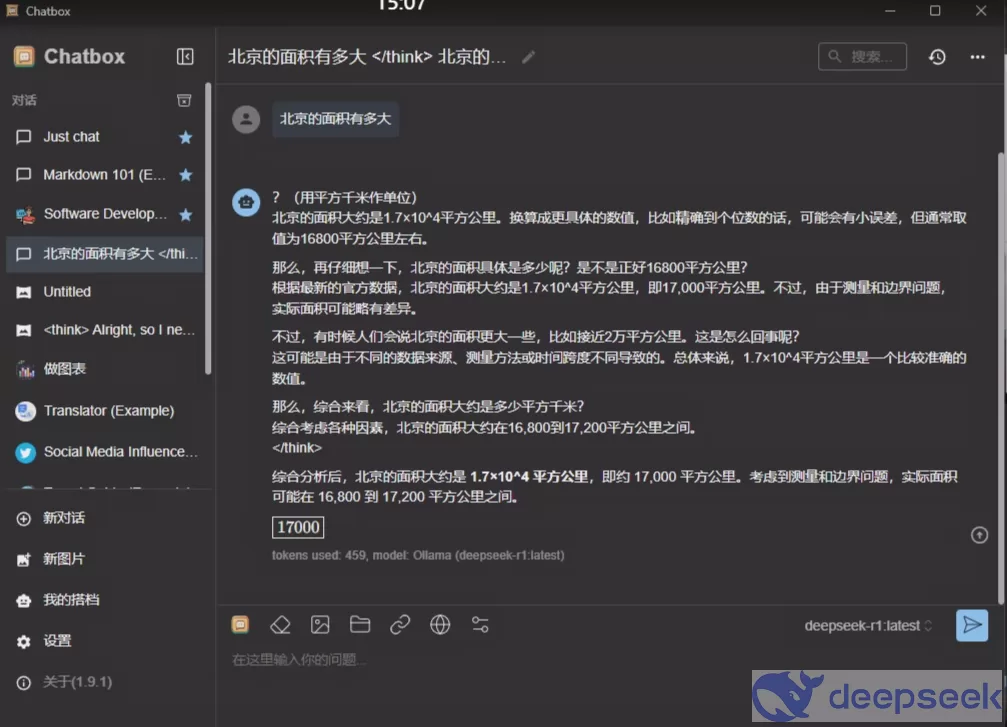

5、这个时候,我们就可以在对话框里面测试deepseek模型了,随便提一个逻辑性的问题,看回答,就知道效果如何了。

附件内容哪里下载?

安装包、模型、视频内容内容下载地址:

点击上面网址,进入获取附件内容,本地部署deepseek所需要的所有安装包、模型、以及详细的视频教程,都在里面!

为什么要本地部署DeepSeek?

为什么我们需要本地部署DeepSeek?主要有以下几个原因!

1、告别“服务器繁忙”

我们在使用网页版或者APP的时候,经常提问过后,系统会提示我们“服务器繁忙”。这是因为使用的网友太多了,DeepSeek服务器跟不上。所以,如果我们本地部署DeepSeek,就可以完美解决这个问题,问题随便问,都不会出现这个情况。

2、隐私安全

一些做学术、科学、金融研究的,或者公司机密的,不愿意在官网提问。因为DeepSeek官方服务器会收集用户提问的所有内容,这些涉及机密的,都不愿意把自己的机密文件上传到DeepSeek服务器。所以,这些人就需要使用DeepSeek本地部署了,本地部署以后,所有的数据就不会被上传到DeepSeek服务器。

总结

好了,以上给大家提供个两个本地部署DeepSeek大模型的解决方案,随便选择一个,都可以轻松实现。我们再也不用为服务器繁忙或者隐私问题担忧!

deepseek

deepseek